Die Debatte um KI-Bewusstsein ist zurück. Fakt oder Ablenkung? David Lott analysiert, warum Big Tech diese Diskussion liebt und worauf IT-Entscheider wirklich achten müssen.

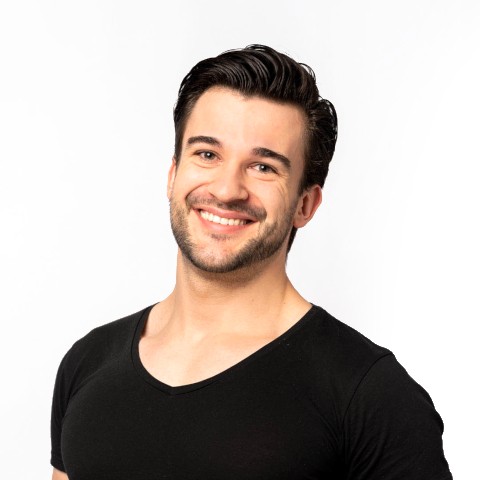

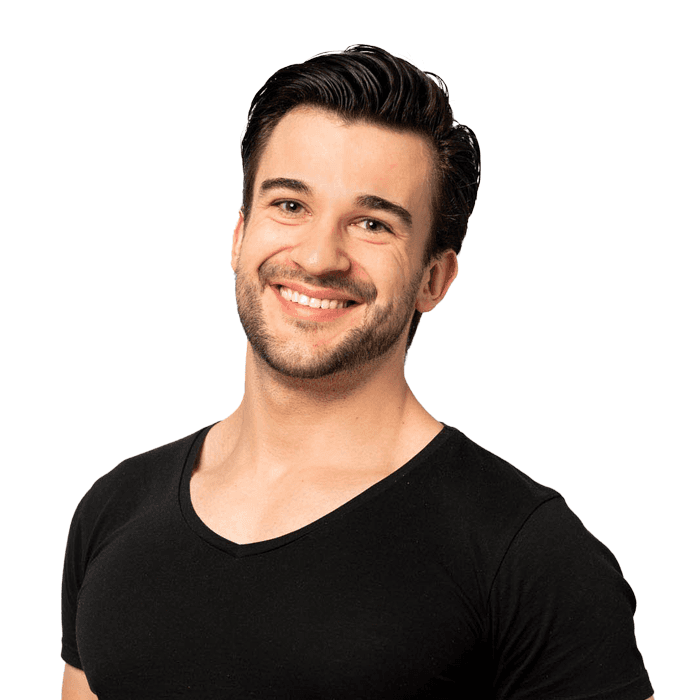

David Lott

am

11.12.2025

Das Märchen vom fehlenden KI-Bewusstsein: Ein Ablenkungsmanöver von Big Tech

Die Debatte um das KI-Bewusstsein ist zurück – und sie ist lauter denn je. Kürzlich stellte sich Microsofts KI-Chef Mustafa Suleyman hin und verkündete fast schon dogmatisch: „KI hat kein Bewusstsein und wird es nie haben.“

Das klingt beruhigend, oder? Eine klare Kante. Ein unaufgeregtes „Weitergehen, hier gibt es nichts zu sehen“ von einem der mächtigsten Männer der Branche. Aber wir müssen uns als Entscheider fragen: Ist diese Aussage ein wissenschaftlicher Fakt – oder ist sie einfach nur verdammt praktisch?

Sie haben wenig Zeit? Hier erkläre ich den Kern der Täuschung in 2 Minuten:

Die Arroganz der Gewissheit

Die KI-Forscherin Maya Ackerman hat kürzlich einen wunden Punkt in Suleymans Aussage getroffen. Ihr Gegenargument ist simpel, aber vernichtend: Wie können wir KI-Bewusstsein kategorisch ausschließen, wenn wir nicht einmal unser eigenes Bewusstsein verstehen?

Wir können es nicht messen. Wir können es nicht universell definieren. Wir verstehen kaum, wie das menschliche Gehirn das Erlebnis des „Seins“ produziert. Sich hinzustellen und mit absoluter Sicherheit zu behaupten, eine Maschine könne dies niemals erlangen, ist keine Wissenschaft. Es ist Wunschdenken. Oder schlimmer: Es ist Kalkül.

Und seien wir ehrlich: Für Tech-Konzerne ist diese Haltung Gold wert.

Warum Big Tech die „Zombie“-Narrative liebt

Warum ist Microsoft (und anderen) so sehr daran gelegen, KI als totes Werkzeug zu deklarieren? Die Antwort findet sich nicht in Philosophie-Büchern, sondern in den Bilanzen.

Wenn wir uns darauf einigen, dass KI nur „Code“ ist, nur ein Werkzeug, nur ein toter Gegenstand, dann ändert sich die ethische Debatte. Wenn es kein Potenzial für KI-Bewusstsein gibt, gibt es keine unangenehmen Fragen nach der Natur der Entität, die wir da erschaffen. Aber viel wichtiger: Wenn wir uns auf die Unmöglichkeit von Bewusstsein fokussieren, schauen wir nicht mehr auf die Realität der Verantwortung.

Es ist die perfekte Nebelkerze. Solange wir darüber diskutieren, ob ChatGPT Gefühle hat, führen wir nicht die Debatte, die eigentlich zählt: Die Debatte über Ethik, Datensouveränität und unternehmerische Haftung.

Ein historisches Muster der Verantwortungslosigkeit

Es ist dieselbe alte Leier. Wir Menschen haben eine lange Geschichte darin, Verantwortung herunterzuspielen, wenn es unserem Profit dient.

Massentierhaltung: Wir reden uns ein, Tiere spüren nicht viel, damit die Effizienz stimmt.

Abholzung: Wälder sind „nur Holz“, keine komplexen Ökosysteme, die wir zerstören.

Gig Economy: Mitarbeiter sind „unabhängige Auftragnehmer“, um Sozialabgaben zu sparen.

Und jetzt, beim Thema KI, sehen wir dasselbe Muster. Indem sie das KI-Bewusstsein für unmöglich erklären, versuchen sich die Tech-Giganten präventiv freizusprechen. Sie wollen Jobs ersetzen, urheberrechtlich geschützte Daten absaugen und Märkte dominieren, ohne die schwere Last ethischer Ambiguität zu tragen.

Die wahre Gefahr für IT-Entscheider

Was bedeutet das nun für uns – für die CISOs, die Geschäftsführer und IT-Leiter in Deutschland? Müssen wir uns sorgen, dass unsere Server morgen aufwachen und streiken?

Nein. Genau das ist die Ablenkung.

Der Punkt ist nicht, ob KI fühlen kann. Der Punkt ist, dass diese Debatte uns blind macht. Während wir über Sci-Fi-Szenarien philosophieren, schaffen US-Konzerne Fakten:

Daten-Monopole: Sie trainieren ihre Modelle mit Ihren Unternehmensdaten.

Abhängigkeit: Sie bauen Ökosysteme, die einen Wechsel fast unmöglich machen (Vendor Lock-in).

Fehlende Haftung: Sie rollen Systeme aus, die halluzinieren und diskriminieren, verstecken sich aber hinter dem „Beta-Status“.

Wir müssen aufhören, auf den Horizont zu starren und uns zu fragen, ob die Maschine „lebt“. Wir müssen auf den Code, die AGB und die Datenflüsse schauen, die direkt vor uns liegen.

Souveränität statt Philosophie

Bei Vective und SafeChats verfolgen wir einen anderen Ansatz. Mir ist es egal, ob eine KI den Turing-Test für Bewusstsein besteht. Mir ist wichtig, ob sie Ihre Geschäftsgeheimnisse für sich behält.

Die wahre ethische Verpflichtung von KI heute dreht sich nicht darum, die KI nett zu behandeln; es geht darum, die Nutzer und deren Daten mit Respekt zu behandeln. Es geht darum, Systeme zu bauen, die transparent, sicher und souverän sind.

Wir müssen lernen, mit der Ungewissheit bezüglich der Natur der KI zu leben – so wie es Maya Ackerman fordert. Aber wir können uns keine Ungewissheit bezüglich der Sicherheit unserer Daten leisten.

Lassen Sie sich nicht von philosophischen Geistergeschichten ablenken. Fordern Sie Verantwortung. Fordern Sie Souveränität.

Basiert Ihre KI-Strategie auf Hype oder Sicherheit?

Hören Sie auf, sich auf Anbieter zu verlassen, die sich hinter Marketing-Nebel verstecken. Erleben Sie echte Datensouveränität mit einer europäischen Alternative.